1. 背景

EU AI 法 (規則 (EU) 2024/1689) は、安全と基本的権利を保護しながら、リスク階層管理を通じて信頼できる人工知能の開発を促進することを目的とした、人工知能に関する世界初の包括的な法的枠組みです。

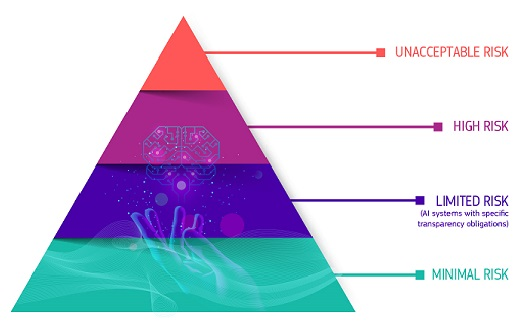

2. リスク分類

許容- できないリスク: ソーシャルスコアリング、公共の場でのリアルタイム顔認識など、禁止されているアプリケーション。

- 高リスク: 医療、教育、公共インフラ、法執行機関、その他の分野が関与し、セキュリティ、透明性、人間の監督などのコンプライアンス要件を満たす必要があります。

- リスクの制限: ユーザーは AI の使用について明確に知らされる必要があります。 最小

- 限のリスク: スパム フィルターなど、追加の監視なし。

- 汎用人工知能モデル (GPAI) には追加の透明性とセキュリティ評価要件が課され、非常に高性能なモデルはより厳しい監視の対象となります。

3. 規制メカニズム

EU AI オフィス (AI オフィス) は、規制の全体的な実施と一般的な AI 監督を担当し、加盟国の市場規制当局は国内コンプライアンス検査を担当し、欧州人工知能委員会、科学専門家グループ、諮問フォーラムによって管理されています。

4. 支援措置

GPAI 行動規範は、企業が透明性、セキュリティ、著作権保護の観点から自己規律メカニズムを確立するよう指導し、モデル プロバイダーが事前に規制要件に適応できるよう支援するために開始されました。

詳細については、公式ウェブサイトを参照してください:

https://digital-strategy.ec.europa.eu/en/policies/regulatory-framework-ai